Dietro le quinte: Il nostro laboratorio ML

Cosa c'è dentro

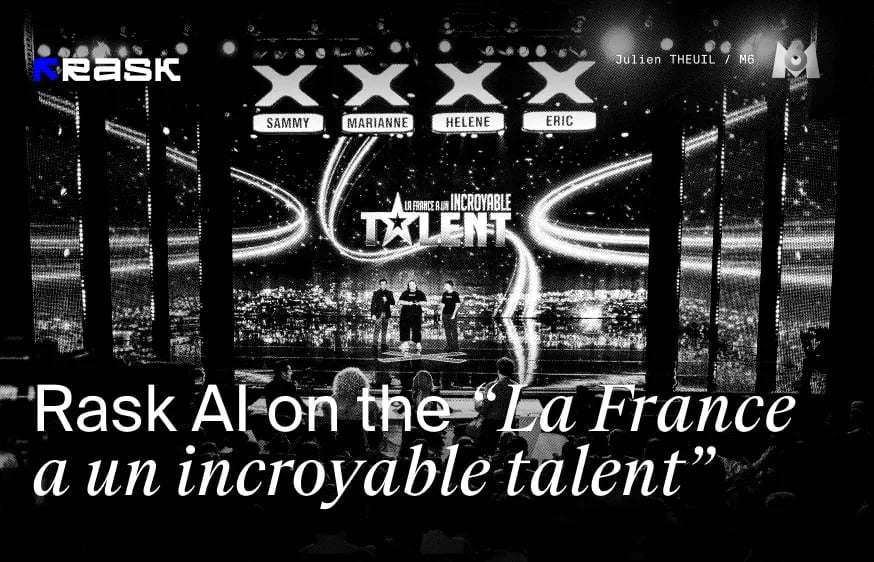

Nel nostro ultimo articolo, ci immergiamo nell'entusiasmante mondo della tecnologia di sincronizzazione labiale diRask AI, con la guida del responsabile dell'apprendimento automatico dell'azienda Dima Vypirailenko. Vi portiamo dietro le quinte del Brask ML Lab, un centro di eccellenza per la tecnologia, dove vediamo in prima persona come questo innovativo strumento di IA stia facendo faville nella creazione e distribuzione di contenuti. Il nostro team comprende ingegneri ML di livello mondiale e artisti sintetici VFX che non si stanno solo adattando al futuro, ma lo stanno creando.

Unitevi a noi per scoprire come questa tecnologia sta trasformando l'industria creativa, riducendo i costi e aiutando i creatori a raggiungere il pubblico di tutto il mondo.

Che cos'è la tecnologia Lip-Sync?

Una delle sfide principali della localizzazione video è il movimento innaturale delle labbra. La tecnologia Lip-sync è stata progettata per aiutare a sincronizzare efficacemente i movimenti delle labbra con le tracce audio multilingue.

Come abbiamo appreso dal nostro ultimo articolo, la tecnica di sincronizzazione labiale è molto più complessa rispetto alla semplice sincronizzazione dei tempi: è necessario ottenere i giusti movimenti della bocca. Tutte le parole pronunciate avranno un effetto sul volto dell'oratore, ad esempio la "O" creerà ovviamente una forma ovale della bocca, quindi non sarà una "M", aggiungendo molta più complessità al processo di doppiaggio.

Vi presentiamo il nuovo modello Lip-sync con una qualità migliore!

Il nostro team ML ha deciso di migliorare il modello di sincronizzazione labiale esistente. Qual è il motivo di questa decisione e quali sono le novità di questa versione rispetto alla versione beta?

Sono stati compiuti sforzi significativi per migliorare il modello, tra cui:

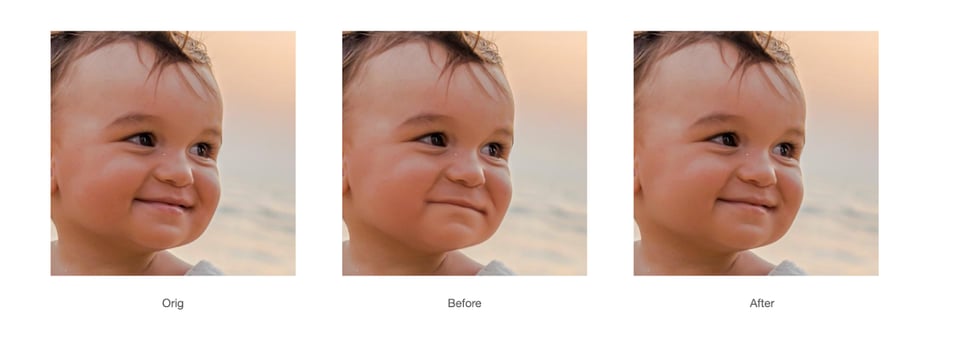

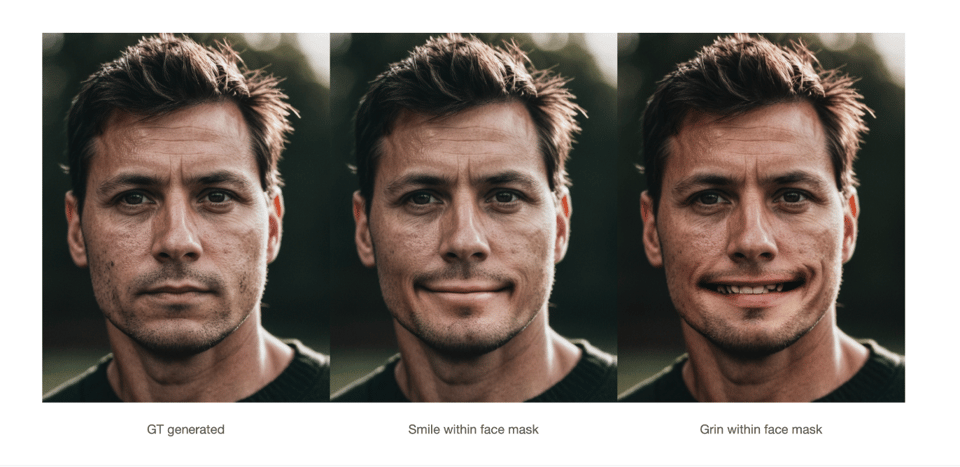

- Accuratezza migliorata: Abbiamo perfezionato gli algoritmi dell'intelligenza artificiale per analizzare meglio i dettagli fonetici della lingua parlata, ottenendo movimenti delle labbra più precisi e strettamente sincronizzati con l'audio in più lingue.

- Maggiorenaturalezza: Grazie all'integrazione di dati di motion capture più avanzati e all'affinamento delle tecniche di apprendimento automatico, abbiamo migliorato in modo significativo la naturalezza dei movimenti delle labbra, facendo apparire il parlato dei personaggi più fluido e realistico.

- Maggiorevelocità ed efficienza: Abbiamo ottimizzato il modello per elaborare i video più velocemente senza sacrificare la qualità, favorendo tempi più rapidi per i progetti che richiedono una localizzazione su larga scala.

- Incorporazione del feedback degli utenti: Abbiamo raccolto attivamente il feedback degli utenti della versione beta e abbiamo incorporato le loro intuizioni nel processo di sviluppo per risolvere problemi specifici e migliorare la soddisfazione generale degli utenti.

Come fa il nostro modello AI a sincronizzare i movimenti delle labbra con l'audio tradotto?

Dima: "Il nostro modello di intelligenza artificiale funziona combinando le informazioni dell'audio tradotto con le informazioni sul volto della persona inquadrata, per poi fonderle nell'output finale. Questa integrazione garantisce che i movimenti delle labbra siano accuratamente sincronizzati con il discorso tradotto, offrendo un'esperienza visiva senza soluzione di continuità".

Quali sono le caratteristiche uniche che rendono Premium Lip-Sync ideale per i contenuti di alta qualità?

Dima: "Premium Lip-sync è stato progettato specificamente per gestire contenuti di alta qualità grazie alle sue caratteristiche uniche, come la capacità di gestire più altoparlanti e il supporto dell'alta risoluzione. È in grado di elaborare video con risoluzione fino a 2K, garantendo il mantenimento della qualità visiva senza compromessi. Inoltre, la funzione multispeaker consente una sincronizzazione labiale accurata tra diversi altoparlanti all'interno dello stesso video, rendendolo molto efficace per produzioni complesse che coinvolgono più personaggi o altoparlanti. Queste caratteristiche rendono Premium Lipsync la scelta migliore per i creatori di contenuti di livello professionale".

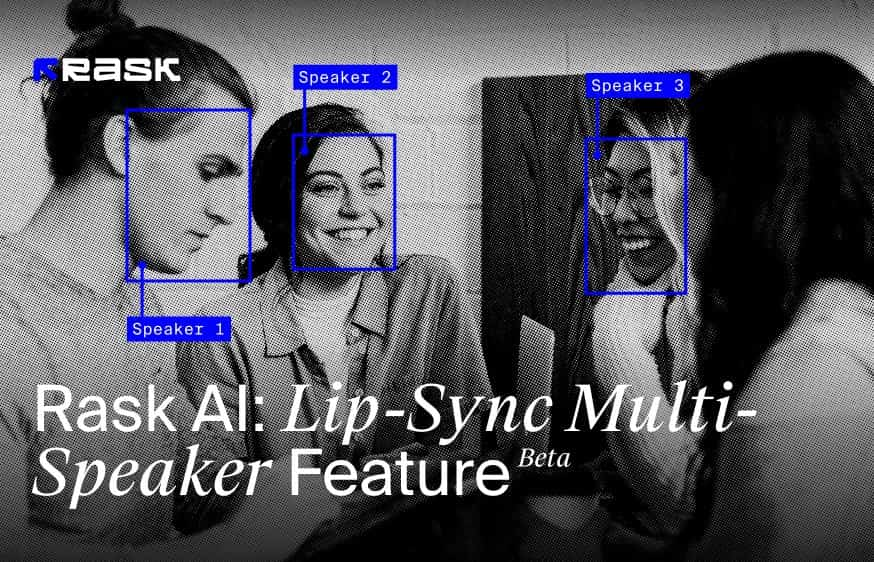

E cos'è la funzione Lip-Sync Multi-Speaker?

La funzione Multi-Speaker Lip-Sync è progettata per sincronizzare con precisione i movimenti delle labbra con l'audio parlato nei video in cui sono presenti più persone. Questa tecnologia avanzata identifica e distingue più volti in un singolo fotogramma, assicurando che i movimenti labiali di ciascun individuo siano animati correttamente in base alle parole pronunciate.

Come funziona la sincronizzazione labiale con più altoparlanti:

- Riconoscimento dei volti nel fotogramma: Questa funzione riconosce inizialmente tutti i volti presenti nel fotogramma video, indipendentemente dal numero. È in grado di identificare ogni singolo individuo, il che è fondamentale per una sincronizzazione labiale accurata.

- AudioMatching: durante la riproduzione del video, la tecnologia allinea la traccia audio in modo specifico con la persona che sta parlando. Questo preciso processo di corrispondenza assicura che la voce e i movimenti delle labbra siano sincronizzati.

- Sincronizzazione del movimento labiale: Una volta identificato l'individuo che parla, la funzione di sincronizzazione labiale ridisegna i movimenti delle labbra solo per la persona che parla. Gli individui non parlanti presenti nell'inquadratura non subiranno alcuna modifica dei movimenti labiali, mantenendo il loro stato naturale per tutto il video. Questa sincronizzazione si applica esclusivamente all'oratore attivo, rendendola efficace anche in presenza di voci fuori campo o di più volti nella scena.

- Gestione diimmagini statiche di labbra: è interessante notare che questa tecnologia è anche abbastanza sofisticata da ridisegnare i movimenti delle labbra su immagini statiche di labbra se queste appaiono nell'inquadratura video, dimostrando la sua versatilità.

La funzione Multi-Speaker Lip-Sync migliora il realismo e il coinvolgimento dello spettatore nelle scene con più oratori o in ambientazioni video complesse, garantendo che solo le labbra delle persone che parlano si muovano in accordo con l'audio. Questo approccio mirato aiuta a mantenere l'attenzione sull'oratore attivo e a preservare le dinamiche naturali delle interazioni di gruppo nei video.

Da un solo video, in qualsiasi lingua, è possibile creare centinaia di video personalizzati con varie offerte in più lingue. Questa versatilità rivoluziona il modo in cui gli addetti al marketing possono coinvolgere un pubblico eterogeneo e globale, migliorando l'impatto e la portata dei contenuti promozionali.

Come si concilia la qualità e la velocità di elaborazione nel nuovo Lip-sync Premium?

Dima: "Bilanciare l'alta qualità con la velocità di elaborazione di Premium Lipsync è una sfida, ma abbiamo fatto notevoli passi avanti nell'ottimizzazione dell'inferenza del nostro modello. Questa ottimizzazione ci permette di ottenere la migliore qualità possibile a una velocità decente".

Ci sono imperfezioni o sorprese interessanti che avete riscontrato durante l'addestramento del modello?

Inoltre, lavorare con le occlusioni intorno alla bocca si è rivelato piuttosto difficile. Questi elementi richiedono un'attenta cura dei dettagli e una modellazione sofisticata per ottenere una rappresentazione realistica e accurata nella nostra tecnologia di sincronizzazione labiale.

In che modo il team ML garantisce la privacy e la protezione dei dati degli utenti durante l'elaborazione dei materiali video?

Dima: Il nostro team di ML prende molto sul serio la privacy e la protezione dei dati degli utenti. Per il modello Lipsync non utilizziamo i dati dei clienti per l'addestramento, eliminando così qualsiasi rischio di furto di identità. Per l'addestramento del nostro modello ci affidiamo esclusivamente a dati open-source dotati di licenze appropriate. Inoltre, il modello funziona come un'istanza separata per ogni utente, garantendo che il video finale venga consegnato solo all'utente specifico ed evitando qualsiasi intreccio di dati.

Il nostro impegno principale è quello di dare potere ai creatori, garantendo un uso responsabile dell'IA nella creazione di contenuti, con particolare attenzione ai diritti legali e alla trasparenza etica. Garantiamo che i vostri video, le vostre foto, le vostre voci e le vostre sembianze non saranno mai utilizzate senza un'autorizzazione esplicita, assicurando la protezione dei vostri dati personali e delle vostre risorse creative.

Siamo orgogliosi di essere membri della Coalition for Content Provenance and Authenticity (C2PA) e della Content Authenticity Initiative, a testimonianza della nostra dedizione all'integrità e all'autenticità dei contenuti nell'era digitale. Inoltre, la nostra fondatrice e CEO, Maria Chmir, è stata riconosciuta nell'elenco Women in AI Ethics™, evidenziando la nostra leadership nelle pratiche etiche di IA.

Quali sono le prospettive future per lo sviluppo della tecnologia lip-sync? Ci sono aree specifiche che la entusiasmano particolarmente?

Dima: Crediamo che la nostra tecnologia di sincronizzazione labiale possa servire come base per un ulteriore sviluppo verso gli avatar digitali. Immaginiamo un futuro in cui chiunque possa creare e localizzare contenuti senza dover sostenere costi di produzione video.

A breve termine, entro i prossimi due mesi, ci impegniamo a migliorare le prestazioni e la qualità del nostro modello. Il nostro obiettivo è garantire un funzionamento fluido sui video 4K e migliorare la funzionalità con i video tradotti nelle lingue asiatiche. Questi miglioramenti sono fondamentali per ampliare l'accessibilità e l'usabilità della nostra tecnologia, aprendo la strada ad applicazioni innovative nella creazione di contenuti digitali. Provate la nostra funzionalità di sincronizzazione labiale migliorata e inviateci il vostro feedback su questa funzione.

FAQ

La sincronizzazione labiale è disponibile sui piani Creator Pro, Archive Pro, Business ed Enterprise.

Un minuto di sincronizzazione labiale generato equivale a un minuto dedotto dal saldo totale dei minuti.

I minuti di sincronizzazione labiale vengono detratti come per il doppiaggio dei video.

La sincronizzazione labiale viene addebitata separatamente dal doppiaggio. Ad esempio, per tradurre e sincronizzare il labiale di un video di 1 minuto in una lingua, sono necessari 2 minuti.

Prima di generare il labiale, è possibile provare 1 minuto gratuito per valutare la qualità della tecnologia.

La velocità di generazione della sincronizzazione labiale dipende dal numero di altoparlanti presenti nel video, dalla durata, dalla qualità e dalle dimensioni del video.

Ad esempio, ecco la velocità approssimativa di generazione della sincronizzazione labiale per diversi video:

Video con un solo relatore

- 4 minuti di video 1080p ≈ 29 minuti

- 10 minuti 1080p ≈ 2 ore e 10 minuti

- 10 minuti di video 4K ≈ 8 ore

Video con 3 relatori:

- 10 minuti 1080p ≈ 5 ore e 20 minuti

- Caricare il video tramite il link da YouTube, Google Drive o caricare direttamente il file dal proprio dispositivo. Scegliere la lingua di destinazione e fare clic sul pulsante Traduci.

- Aggiungete una voce fuori campo al vostro video in Rask AI tramite il pulsante "Dub video".

- Per verificare se il video è compatibile con la sincronizzazione labiale, fare clic sul pulsante "Verifica sincronizzazione labiale".

- Se è compatibile, procedere toccando il pulsante Lip-sync.

- Quindi, selezionare il numero di volti che si desidera inserire nel video: "1" o "2+", quindi toccare "Avvia sincronizzazione labiale". Per informazione, si tratta del numero di facce, non degli altoparlanti.

Rask%20Lens%20A%20Recap%204.webp)